日前,香橙派官方发布OrangePi AIpro(20T)运行Deepseek-R1蒸馏模型实操指南,帮助用户通过先进算力和硬件架构实现高效的端侧智能。

OrangePi AIpro(20T)是香橙派联合昇腾 AI打造的高算力开发板,根植于昇腾AI技术,集 AI计算、ISP、图形输出等功能于一体,释放高达 20 TOPS的AI算力。可配24GB运行内存,汇聚了MIPI DSI、双MIPI CSI、USB3.0、Type-C、双HDMI2.0、双2.5G以太网、支持SATA/NVMe SSD 2280的M.2插槽等各类流行的接口。OrangePi AIpro(20T)依托昇腾AI基础软硬件能力的基础,融合大模型与训推一体化优势,实现端边云全场景无缝部署,是构建昇腾计算产品、使能上层软件和应用的底座,有高算力、高能效等特性。

该产品广泛应用于AI边缘计算、深度视觉与视频流分析、自然语言处理、智能机器人(如小车、机械臂)、无人机、云计算、AR/VR、智能安防及家居等AIoT全领域,引领行业智能化转型。

基于昇腾硬件底座、昇腾异构计算架构CANN、昇思Mindspore AI框架以及 MindlE推理引擎,用户可以通过OrangePi Alpro(20T)开展面向金融、教育、政务、智能制造、智能家居、智慧交通等行业的人工智能应用开发。

OrangePi AIpro(20T)运行Deepseek-R1蒸馏模型

据了解,DeepSeek-R1专为数学、代码生成和复杂逻辑推理任务设计,通过大规模强化学习(RL)提升推理能力,还摒弃监督微调(SFT),采用纯强化学习(GRPO算法)训练基座模型。同时,DeepSeek-R1提供了高效模型蒸馏技术,可将大规模模型能力迁移至更小、更高效的版本,优化模型性能、开源应用。经蒸馏后的DeepSeek-R1模型支持部署于端侧,大幅降低计算资源需求,显著提升端侧设备的AI推理效率。

除OrangePi AIpro(20T)之外,迅龙软件也发布了OrangePi AI Studio、OrangePi 5Plus运行Deepseek-R1蒸馏模型的实操指南。迅龙软件表示,未来将继续加大研发投入,携手行业伙伴,推动不同算力等级的开发板与DeepSeek等优质模型相结合,进一步降低端侧AI的门槛,为客户创造更大的AI价值。

实操指南

DeepSeek-R1-Distill-Qwen-1.5B

1) 下载最新的desktop版本镜像。

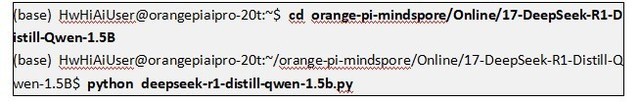

2) 执行以下命令启动推理。

3) 第一次启动会自动下载模型,具体时间视网络环境而定,模型会被下载到“~/orange-pi-mindspore/Online/17-DeepSeek-R1-Distill-Qwen-1.5B/.mindnlp/model/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B/”文件夹内。

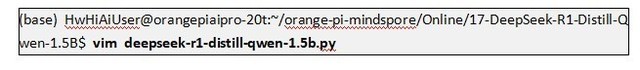

4) 推理代码默认在启动的时候会检查相关的依赖,此时如果网络环境不好,会导致无法启动。如果不是第一次启动,且模型已经下载完成,可以按照下图所示,修改tokenizer和model参数,将路径改成本地绝对路径,这样就可以离线启动了。

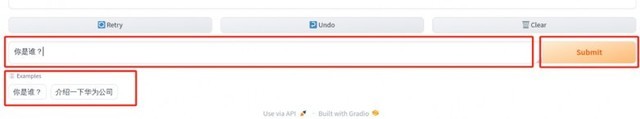

5) 等待一会,会出现一个ip,复制到开发板上的浏览器的地址栏访问。

6) 启动后,可在页面下方消息输入框“Type a message…”中输入任何问题,或者点击下方Examples中设置好的问题,然后点击右侧的“Submit”按钮,Qwen模型将对此进行回答。

7) 第一次回答需要较长时间加载,大约需要1分钟,请耐心等待。回答将显示在上方聊天框中。

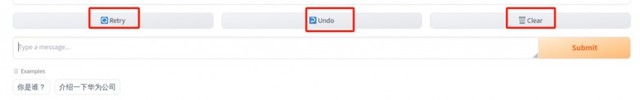

8) 如果出现Error,可以点击“retry”按钮重新发送上一条消息,并让模型重新回答;点击“undo”按钮可撤回上一条消息;点击“clear”按钮将清空聊天框中的对话。

9) 输出结果如下图所示:

本文属于原创文章,如若转载,请注明来源:OrangePi AIpro(20T)本地部署Deepseek-R1蒸馏模型指南https://price.zol.com.cn/949/9493422.html